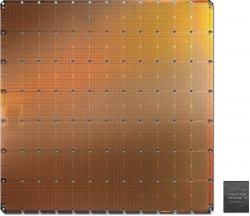

Asi tak před rokem kalifornský startup Cerebras Systems ohromil svět svým unikátním čipem nebo spíše celým waferem WSE, s 1,2 biliony tranzistorů a téměř 400 tisíci programovatelných výpočetních jader. Už tehdy se mluvilo o tom, že megačip WSE je vlastně celý superpočítač na čipu s ohromujícím výkonem. Cerebras záhy vytvořil počítačový systém CS-1, který používá právě čip WSE. A jak se zdá, rekordně velký čip si superlativy rozhodně zaslouží.

Cerebras nedávno zveřejnil, že jejich počítačový systém CS-1 změřil síly v simulaci elektrárenských spalovacích procesů se superpočítačem Joule 2.0. Tento superpočítač pracuje v laboratořích National Energy Technology Laboratory (NETL). Jde o momentálně 81. nejvýkonnější superpočítač světa, který má k dispozici 271 TB paměti, může uložit 11,6 PB dat a jeho síť přenáší data rychlostí 83,2 TB za sekundu.

Přesto se Joule 2.0 s počítačovým systémem CS-1 nemůže měřit. Ten zmíněné simulace zvládá 200 krát rychleji. Jak skromně uvedli šéf týmu Cerebras Michael James a Dirk Van Essendelft z amerického ministerstva energetiky, pro CS-1 s megačipem WSE nejsou soudobé superpočítače důstojným soupeřem. A to bez ohledu na počet procesorů a grafických procesorů, které mají k dispozici.

Superpočítač Joule 2.0 využívá čipy Intel Xeon po 20 výpočetních jádrech, přičemž těchto jader má celkem 16 tisíc. Megačip WSE má výpočetních jader zhruba 25 krát víc, plus 18 GB paměti RAM. Prvky čipu spojuje komunikační systém Swarm, který přenáší data rychlostí 100 PB za sekundu. Joule zvládl simulaci elektrárenských spalovacích procesů za 6 milisekund a CS-1 ho deklasoval za 28 mikrosekund.

Šéf Cerebras Systems Andrew Feldman nepochybuje, že pro tento typ výpočtů je jejich CS-1 nejrychlejším počítačem, co byl zatím postaven. Je rychlejší než jakákoliv dosavadní kombinace čipů a procesorů. Je dokonce tak rychlý, že spočítá simulaci elektrárenských spalovacích procesů rychleji, než takový proces v reálném čase proběhne. Podle svých tvůrců je tedy vlastně rychlejší než fyzika. Klíčem k úspěchu systému CS-1 je podle všeho především práce megačipu WSE s pamětí. I když má superpočítač Joule jednoznačně větší paměť, tak ji nedokáže využívat tak efektivně jako CS-1.

Video: How Cerebras Built the World’s First Wafer-Scale Processor

Literatura

Superpočítač Trinity simuloval DNA s rekordní miliardou atomů

Autor: Stanislav Mihulka (26.04.2019)

Unikátní escherovský čip simuluje interakce částic v hyperbolické geometrii

Autor: Stanislav Mihulka (15.07.2019)

Nejrychlejší počítač pro umělou inteligencí má v sobě největší čip na světě

Autor: Stanislav Mihulka (25.11.2019)

Diskuze:

Technické a fyzikální výpočty vs. zbytek světa

Martin Prokš,2020-12-01 09:50:14

Dobrý den,

Je to již před deset let co do technických a fyzikálních výpočtů nedělám (no já to aktivně pořádně nedělal nikdy, jen jsem s tím koketoval a pak jsem přešel na pozici správce výpočetního clusteru). Ale co si pamatuji z prouďařiny (CFD) tak problémy jsou:

1) Fyzikální výpočty jsou jen zlomek světa - o takové počítače "skoro" není zájem. Těch organizací které by si je pořídili je tak málo, že specializované počítače se nezaplatí. Respektive pár se jich dělá, ale cena/výkon je strašlivá protože náklady se rozpočítávají do pár kousků. Zatímco databází, IT a podobně úloh je ve světě mraky a chce to každý, takže se náklady rozpustí ve velkých sériích a cena je přijatelná. Takže fyzici jsou ve většině případů odkázáni na neoptimální HW. Čest výjimkám jako je tohle a ostatní superpočítače.

2) Situace se začla trošku měnit s nástupem masivního computingu na grafických kartách právě před cca 10 lety.

3) Mnoho fyzikálních úkolů lze na úrovni samotného výpočtu masivně paralelizovat (druhá věc pak je licenční politika vláken a procesů u technických komerčních SW). CFD, MKP, teplo, chemie, ... Tak jak to tu už někteří popisovali. Kritická je rychlost výměny dat mezi procesory - optimalizace výpočetních přesahů, synchronizačních taktů a tak. Pro CFD a klasické procesory na desce s klasickou RAM jsme před 10 lety byly na optimálním poměru 16 procesorů a 512MB RAM na procesor, maximum 1024MB RAM na procesor. Prostě bojujete propustností RAM-CPU a výměnou dat mezi vlákny, nebo nedej bože mezi jednotlivými počítači. Takže pokud jsou všechny procesory na jednom čipu a mají mezi sebou výměnu dat prakticky bez zdržení, pak 45kB na CPU nemusí být zcestné, hodně záleží na typu úlohy.

4) Ten opravdový problém s reálnými úlohami ale často je (alespoň v CFD a MKP) v pre-processingu a post-processingu. Příprava sítě a okrajových podmínek, to těžko paralelizujete. Stejně tak potom celkové vyhodnocení výsledků není moc vhodné na paralelizaci. Nevím jestli se za těch 10 let situace někam hnula, ale tohle byl ten největší žrout času a často reálně omezoval velikost zvládnutelné úlohy.

Ale dnes už do toho přes 10 let nedělám, třeba se situace někam pohla. Docela by mě to pro zajímavost zajímalo.

Rychlost

Josef Šoltes,2020-11-30 09:08:12

Pokud je tak rychlý a pokud nevyžaduje extrémní příkon a šlo by ho vyrábět masověji, možná by to byl ideální systém pro přesné řízení spalování v elektrárnách, protože by dokázal nasimulovat procesy rychleji, než proběhnou a provádět úpravy v reálném čase.

Re: Rychlost

Petr Pavlata,2020-12-02 08:43:49

Výtěžnost takto velkého čipu bude příšerná, pokud to dělají z jednohu kusu, bude velmi drahý.

Pro srovnání - top FPGA s 30G tranzistory, které se relativně ve velkém vyrábí (ale proto tomuto má stále jen zlomek plochy) stojí cca 1 milion kč.

Na druhou stranu využití si to jistně najde, nedávno jsem četl článek jak velký problém je upočítat magnetické pole v moderních tokamacích.... Tam vysoký výpočetní výkon, ale hlavně i velmi malá latence proti běžnému systému určitě bude výhoda. I za těch několik milionů dolarů, co to bude stát.

Příkon bude v jednotkám, možná kolem desítky kW. Horší bude chlazení, odvést kolik tepla je problém.

Hlavní je chlazení...

Petr V,2020-11-30 04:40:36

Jak je řešeno chlazení? Nebo ten výpočet je jen krátký, kdy nedojde k přehřátí?

V řádu milisekund velký výkon...

Paralelní programování neumím, ale mám v hlavě vzor jménem mozek.

Tak třeba to dám...

Re: Hlavní je chlazení...

F M,2020-11-30 19:09:02

Zde je pár odpovědí, něco je i přímo na cerebras

Https://diit.cz/clanek/cerebras-predstavila-nejvetsi-procesor-na-svete

Luna myšlení

Alois Všeználek,2020-11-29 14:21:24

Tak už víme proč se cpou Číňani na Měsíc.

Re: Re: Luna myšlení

Alois Všeználek,2020-11-30 09:57:30

Příznivé podmínky, dostatek místa, to helium bude jako prémie nebo křoví. Kvantovou komunikaci už mají, tak spojení nebude problém.

To jenom tak, aby řeč nestála. :)

Re: Re: Re: Re: Re: Luna myšlení

Alois Všeználek,2020-12-01 01:48:25

Zde je článek. Zkuste pohledat.

Martin Pecka,2020-11-29 10:57:41

45 kB RAM na jadro? Tak s tim se opravdu neda mluvit o general-purpose procesoru, ale spis o procesoru vhodnem jenom na uzkou mnozinu problemu, ktere skoro nepotrebuji pouzivat pamet.

Re:

Peter Somatz,2020-11-29 13:53:19

Tento system je designovany na vykon. Tusim tam je len ALU, FPU, router na 4 susedov a ta 45 kB cache. Pritom 1 jadro je dostatocne univerzalne na akekolvek vypocty. Idealny system, pretoze kazde jadro vie len rychlo vypocitat svoju cast problemu a vysledky posunut inemu jadru. To nevadi ze 1 jadro ma malu pamat. Celkovo to ma 18 GB a ramci systemu k tomu urcite bude mozne pripojit dalsiu externu pamat.

Pritom hardwarovy design je relativne jednoduchy. Taketo nieco tu mohlo byt uz desiatky rokov - mozno nie s tym poctom jadiet, vyrobnym procesov atd. Ale firmy miesto toho ryzovali na zakaznikoch nezmyselnym designom - par jadier s cachami + uzka zbernica + hafo hlavnej pamati. Aby sa vraj nemuseli "trapit" s paralelnym programovanim.

Re:

F M,2020-11-30 20:40:54

Pokud to dobře chápu jde o "akcelerátor" AI, ta se většinou trénuje. A jde spíš o FPGA než klasický procesor, čemuž napovídá ta programovatelnost, dost možná nějaká specifická kombinace. Otázka zní jak dlouho je potřeba na jeho přípravu na konkrétní úkol, případně trénink té AI. Tedy toto nemůžu tvrdit zcela určitě, zase tolik času tomu věnovat nemohu, ale toto mi z toho plyne.

Asi bych to viděl takhle, třeba i malý server v elektrárně, válečné lodi ... toto využívá jako akcelerátor AI výpočtů stejně jako využívá PC grafickou kartu tam kde by jinak bylo potřeba daleko více klasických procesorů.

Miniaturizace

Ivan Polák,2020-11-29 08:56:18

Není co řešit. U takhle výkonných systémů nakonec hraje roli prostě rychlost světla ve vztahu k rozměrům celého zařízení.

Re: Miniaturizace

Peter Somatz,2020-11-29 14:17:21

To je dogma vysoko taktovanych, malojadrovych systemov. Toto je iny pristup - masivny parelelizmus. Vela jadier, ktore rozlozia rieseny problem na mnozstvo ciastkovych uloh. A tam uz sa ani nedaju zabezpecit spolocne hodiny - takt, preto su tam miniroutre.

Rovnako ludsky mozog nie je "taktovany" vysoko - prenos vzruchov je relativny pomaly (oproti pocitacom), napriek tomu ta masivna paralelizacia nam umoznuje riesit problemy, na ktore nebude mat hruby vykon ani milion tychto Cerebrasov a uz vobec nie standardne architektury.

Re: Re: Miniaturizace

Vladimír Bzdušek,2020-11-29 21:51:12

Všeobecná otázka: Aké asi percento problémov (ktoré sa riešia výpočtovou technikou) je možné masívne paralelizovať? Podľa mňa to asi nebude veľa, preto aj vývoj išiel oboma cestami.

Re: Re: Re: Miniaturizace

Peter Somatz,2020-11-29 22:11:36

Neviem ake percento. Ale prakticky vsetky mozne simulacie, kde mate vela castic/prvkov. Ci uz molekularna dynamika - napr. vyvoj liekov, rozne vizualizacie, samozrejme umela inteligencia a od toho sa odvijajuca robotika, az po simulacie galaxii, ciernych dier, vesmiru atd.

Re: Re: Re: Re: Miniaturizace

Vladimír Bzdušek,2020-11-30 00:24:30

OK, nebudem polemizovať, nevyznám sa vo veci. Ale zdá sa mi všeobecne problematická paralelizácia systému, kde súčasný stav prvku ovplyvňujú minulé stavy iných prvkov.

Re: Re: Re: Re: Re: Miniaturizace

Waldir Bezejmenný,2020-11-30 09:32:07

Well, to je důvod proč pro paralelizaci takovýchto systémů je velmi důležitá právě propustnost paměti. Tím si osobně vysvětluji to, že zrychlení uvedené výše je 200 násobné i když systém obsahuje pouze cca 25 krát více jader.

Provázanost systému paralelizaci určitě komplikuje - t.j., snižuje její efektivitu protože je potřeba buď velmi často synchronizovat data (při "jemnozrné" paralelizaci) a nebo synchronizaci dat kompenzovat jejich duplicitním výpočtem (při "hrubozrnější" paralelizaci) - ale pokud jde o výpočty nad velkými systémy, tak není jiná cesta, než to prostě nějak zkousnout - na jednom jádru bych se nedopočítal.

Zrovna fyzikální systémy se dají paralelizovat minimálně v rámci stejného času, tzn. napříč různými "dlaždicemi" prostoru. Pokud navíc je vzdálenost interakce prvků systému omezená, tak je možné "dlaždicovat" i napříč časem, s tím, že vzájemné ovlivnění prvků mezi dlaždicemi je kompenzováno překryvem dlaždic v prostoru.

Pokud jde o systémy kde se ovlivňuje všechno se vším, tak je pořád mohu zkusit rozdlaždicovat podle míry vzájemného ovlivnění, a různé dlaždice synchronizovat proporcionálně míře jejich ovlivnění a zároveň vedle stanovit maximální chybu která je tímto přístupem způsobená. Případně navíc rozdělit do nějaké hierarchie v rámci níž některé míry vlivu budu počítat "centrálně".

Diskuze je otevřená pouze 7dní od zvěřejnění příspěvku nebo na povolení redakce